본 글은 주재걸교수님의 인공지능을 위한 선형대수 강의를 듣고 정리한 내용입니다.

Eigenvectors and Eigenvalues

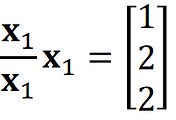

An eigenvector of a square matrix 𝐴 ∈ ℝ𝑛×𝑛 is a nonzero vector 𝐱 ∈ ℝ𝑛 such that 𝐴𝐱 = 𝜆𝐱 for some scalar 𝜆 In this case, 𝜆 is called an eigenvalue of 𝐴, and such an 𝐱 is called an eigenvector corresponding to 𝝀.

x가 eigenvector라면, 𝑇(x) = 𝐴x = 𝜆x 는 같은 방향으로 길이만 𝜆로 scale된 백터를 출력한다.

eigenvalue를 사용하면 A matrix를 사용하는것 보다 연산의 양이 훨씬 줄어든다.

𝐴𝐱 = 𝜆𝐱 -> (𝐴 − 𝜆𝐼)𝐱 = 0

- 𝜆 is an eigenvalue of an 𝑛 × 𝑛 matrix 𝐴 if and only if this equation has a nontrivial solution(해가 하나만 존재하는 방정식일 경우에만 성립)

- The set of all solutions of the above equation is the null space of the matrix (𝐴 − 𝜆𝐼) , which we call the eigenspace of 𝐴 corresponding to 𝝀.

'Study > 선형대수학' 카테고리의 다른 글

| 4-3. 특성방정식 (0) | 2022.01.05 |

|---|---|

| 4-2. 영공간과 직교여공간 (0) | 2022.01.05 |

| 3-5. 그람-슈미트 직교화와 QR 분해 (0) | 2022.01.04 |

| 3-4. Orthogonal Projection (0) | 2022.01.04 |

| 3-3. 정규방정식 (0) | 2022.01.03 |

댓글